Kas eetikal on midagi uute tehnoloogiate kohta öelda?

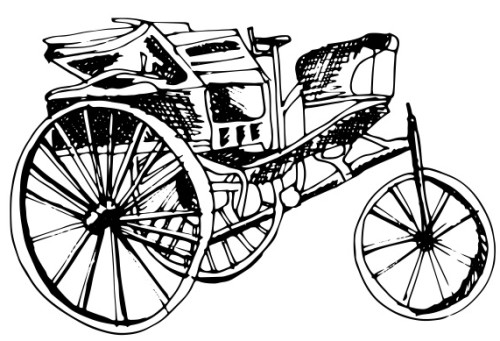

Lugemisaeg 5 minIsesõitvad autod on tulnud, et jääda. Oktoobri keskpaigas jõudis seni rohkem ulmefilmidest ja seriaalist „Knight Rider” tuntud autopiloot tänu Tesla tarkvarauuendusele esimest korda massidesse. Kui aga autopiloodil KITT põrkaks kokku autopiloodil Teslaga, siis kas avariis tuleks päästa Michael Knight või Teslas istuv perekond?

Kui teadlaste ja inseneride pärusmaaks on leida lahendus, kuidas midagi teha – kuidas ehitada tuumapomme või pikendada sureva inimese eluiga –, siis filosoofide ülesanne on vastata küsimusele, miks midagi teha. Mida enam laieneb teaduslik teadmine ümbritsevast maailmast ja mida enam rakendatakse neid teadmisi tehnoloogias, seda tihedamini leiame end olukorrast, kus peaksime hetkeks mõtlema: „Me küll oskame teha asja X, kuid kas me ikka peaksime seda tegema?” Kui näiteks 1970ndatel maadlesid bioeetikud in vitro viljastamise küsimusega – sellele uudsele protseduurile oli väga suur vastuseis –, siis nüüdseks on sellest saanud täiesti tavaline meditsiiniline vahend laste saamiseks, mille abiga on sündinud miljoneid, ja ühtlasi on jäänud ära suuremat sorti moraalne allakäik. Praeguse aja üks sarnane probleemipundar on seotud tehisintellekti ning nutikate masinatega. Isegi nii nutikatega, et neile võiks omistada moraalse staatuse.

Ütlemine, et kellelgi on moraalne staatus, tähendab seda, et peaksime võtma teda arvesse oma moraalsetes kaalutlustes ning saame talle liiga teha. On mitmeid erinevaid teooriaid selle kohta, mis kriteeriumitele peab vastama, et moraalset staatust omada. Üks neist keskendub vaimsetele võimetele: kui vaatluse all olev olend on ratsionaalne, st toetub tegutsemisel impulsside asemel põhjustele, on tal moraalne staatus.

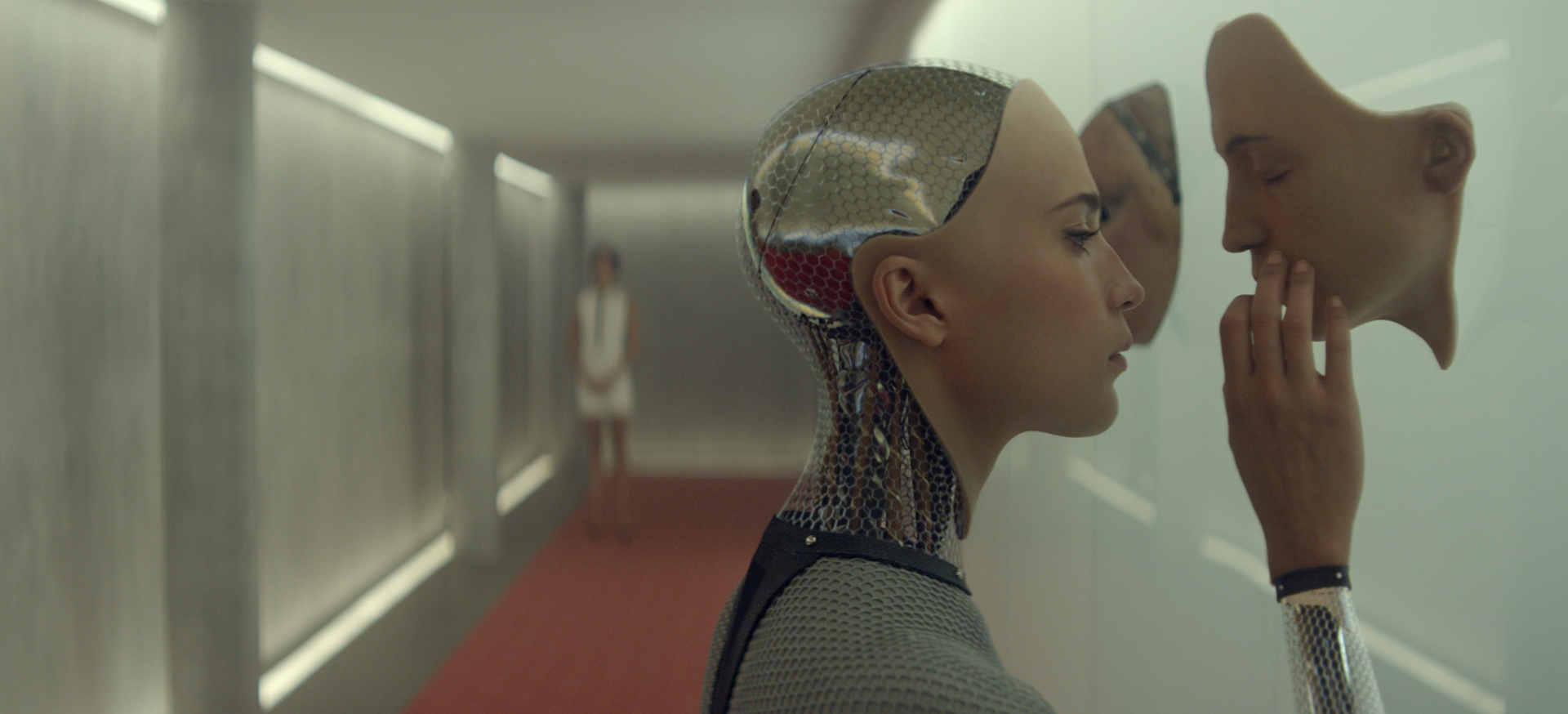

See teooria jätab moraalse staatuseta need, kes meie intuitsioonide järgi peaksid selle saama, näiteks loomad. Tehisintellekti puhul, mis on oma vaimsetelt võimetelt inimesega sarnane, jõuame vastupidise olukorrani – me peaksime omistama moraalse staatuse olendile, kes peaks meie intuitsioonide kohaselt sellest ilma jääma. Programmil, mis mõtleb ning tegutseb sarnaselt inimesega, mis on võimeline mõistma oma tegude tagajärgi ja neile hinnanguid andma ning vastavalt sellele oma käitumist kujundama, peaks olema eespool kirjeldatud teooria järgi inimesega võrdne moraalne staatus. Nendega tuleks arvestada samamoodi nagu teiste inimestega. Seega võib telefoni mittelaadimine olla tulevikus moraalselt halvem tegu kui oma kassi nälga jätmine.

Loomulikult on praegu keeruline öelda, kuidas me hakkame tulevikus tehisintellekti kohtlema, ja võib-olla me ei peaks panema neid kriteeriume paika enne, kui eksisteerivad konkreetsed tehnoloogiad. Ehk peaksime pöörama oma tähelepanu hoopis sellistele tehnoloogiat puudutavatele eetilistele küsimustele, mis on aktuaalsed juba nüüd ja praegu.

Oktoobri keskpaigas väljastas Tesla Motors tarkvarauuenduse, mis lubas Model Sidel autopilooti kasutama hakata. Samamoodi on Google testinud juba aastaid erinevaid versioone isesõitvast autost (ISA). Teisisõnu ei ole ISAd tulevikutehnoloogia. Hoolimata sellest, et ISAd on ilmselt kordades turvalisemad kui praegused inimjuhid, on selge, et kerkib üles küsimus, kes jääb süüdi ja vastutab, kui ISA satub liiklusõnnetusse. Küsimus on eriti oluline situatsioonis, kus ohvrite vältimine ei ole võimalik. ISA ei ole moraalne agent. Tegu on siiski masinaga. Olgugi et see on väga võimekas, lähtub masin oma toimimises siiski programmist. Seega langeb tootjate õlule vastutus luua autodele reeglid, mis vastaksid meie parimale arusaamisele eetiliselt õigest käitumisest liiklusohtlikus olukorras. ISA-l ei ole iseloomu, mida see saaks arendada, ja seetõttu ei saa see oma käitumises vooruslik olla – vooruseetika on siinkohal tähtsusetu. Kuna ISA järgib programmi ja rangelt võttes ei vali see oma tegusid, pole sel ka tahet. See ei saa teha asju õigetel ega valedel motiividel, mis tähendab, et deontoloogilisel eetikal pole siinkohal samuti meile midagi öelda. Seega saab see auto lähtuda vaid teatud tüüpi konsekventsialismist ehk õige toimimise liiklusohtlikus olukorras määravad vaid head tagajärjed.

Selline vastus ütleb meile üsna vähe, sest fraasi „hea tagajärg” saab mitmeti mõista. Näiteks millegi (õnn, mõnu) suurendamine või hoopis millegi halva (ebaõnn, valu) vähendamine, kuid välistatud ei ole ka tagajärje headuse hindamine rahalise kahju alusel. Olenemata sellest, mis on täpselt „hea tagajärje” sisu, saab ISA lähtuda valikute hindamisel vaid andmetest, mis on sellele vastaval hetkel kättesaadavad ning mis on mingil moel kvantitatiivsed. Liiklusohtliku olukorra lahendamisel pole tõenäoliselt väga palju andmeid saadaval. Võimalike ohvrite arvu, tüüpi ja vanust on ilmselt kerge tuvastada ning need näitajad on üsna lihtsalt kvantifitseeritavad: ohvrite arv ning vanus on esitatud numbrina ning inimesed lähevad rohkem arvesse kui loomad ja vara. Kuid ei tundu kuigi realistlik, et andurid suudaksid tabada inimese tervislikku seisundit või tema panust ühiskonda, mida olukorras arvesse võtta. Mis tähendab, et arutelud teemal, kas auto peaks valima noore, kuid rikka ja haige, ning vana, kuid vaese ja terve, inimese vahel, jäävad (vähemalt esialgu) siiski vaid filosoofiaseminaridesse.

Isegi kui pidada silmas üksnes võimalikku ohvrite arvu, tõstatuvad keerukad olukorrad, sest mõned inimesed – meie ise – on teistest olulisemad. Kui „hea tagajärg” määratakse ohvrite väikseima võimaliku arvu alusel, peab ühe inimesega ISA liiklusohtlikus olukorras vastu puud sõitma, et vältida kahele jalakäijale otsasõitmist. Kuid kes tahaks istuda masinasse, mis on programmeeritud teda vajalikul hetkel tapma? Seega tundub mulle, et iga ISA esimene eesmärk peab olema hoida elus oma kaasreisijad ning alles seejärel mõelda teiste võimalike ohvrite peale. Vastasel juhul oleks inimestel ilmselt väga keeruline oma autot usaldada ning seetõttu ka kasutada. Sarnaselt ei tahaks ju keegi meist käia arsti juures, kelle kohta teaksime, et ta võib meid igal hetkel uinutada ja meie organid laiali jagada, kui nii saaks päästa mitme teise inimese elu.

Optimistlik vaade ütleb meile, et 1970ndate bioeetikute näitel ei peaks me liiga palju uute tehnoloogiatega seotud moraaliküsimuste peale mõtlema, sest ajaga kujunevad need asjad iseenesest mingil moel välja. Kerge huumoriga võiks ühtlasi öelda, et me ei peaks oma päid üldse nende küsimustega vaevama, küll meie uued robotvalitsejad ütlevad, mis on õige ja mis väär.